Guide prompt engineering 2026 : transformez vos prompts hasardeux en requêtes IA efficaces

20 minutes perdues. Encore.

Vous venez de passer un quart d’heure à reformuler le même prompt ChatGPT pour obtenir un texte qui ne ressemble toujours pas à ce que vous vouliez. Ca sonne faux, ce n’est pas vous, au final vous abandonnez et vous le faites vous-même en 45 minutes.

Et vous concluez : « L’IA, ça marche pas pour moi. »

Sauf que le problème n’est pas l’IA. C’est le prompt.

90% des utilisateurs traitent ChatGPT comme ils utilisent Google : quelques mots-clés, « Enter », et hop. Ils espèrent un miracle. Mais ce n’est pas comme ça que ça fonctionne.

Pendant ce temps, une minorité prétend avoir conçu des automatisations chatGPT qui leur fournissent des résultats incroyables, authentiques, indétectables. Même s’ils enjolivent parfois la vérité, il est possible d’obtenir des textes qui vous ressemblent et qui répondent à vos besoins.

La différence ? Le prompt engineering.

Derrière cet anglicisme barbare, il n’y a rien de compliqué. Dans cet article on va voir comment structurer un prompt efficace dans les 10 prochaines minutes.

Dans cet article je vous livre :

La structure de base (Contexte-Persona-Rôle-Format) pour des résultats Pro

6 techniques avancées avec exemples concrets

21 templates exploitables dans 7 contextes métier

3 cas d’usage réels (lancement produit, formation en ligne, gestion de crise)

Temps d’application : Immédiat

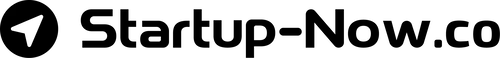

La structure de base du prompt : CPTF

CPTF signifie : Contexte + Persona + Tâche + Format. C’est le squelette minimal d’un prompt structuré.

Pourquoi vos prompts ne donnent pas les résultats attendus

Le manque de cadrage est certainement le problème le plus fréquent. Vous donnez du flou en entrée, vous obtenez du flou en sortie.

Prompt faible typique :

« Écris un article sur les vertues de la sauge »

Résultat ChatGPT :

500 mots génériques que vous auriez pu trouver sur n’importe quel blog. Aucune personnalisation. Aucun angle différenciant. Et par conséquent, aucune raison d’être mis en avant par les moteurs de recherche.

Le diagnostic : Vous n’avez donné ni contexte, ni direction, ni contraintes.

Le framework CPTF expliqué

C – CONTEXTE

Définition du contexte : Votre situation actuelle + votre objectif final.

Pour obtenir des résultats pertinents, vous devez indiquer à votre IA qui vous êtes, pour qui vous écrivez et le résultat final que vous recherchez.

Vous répondez à :

- Où en suis-je maintenant ? (point de départ)

- Que veux-je obtenir précisément ? (résultat attendu)

- Quelles sont mes contraintes/limitations ?

Sans contexte personnel, ChatGPT produit du générique. Avec votre situation réelle, il adapte chaque suggestion à VOS contraintes.

Exemple de contexte : « Je crée une entreprise qui vend des T-shirts personnalisables pour les clubs sportifs et les organisateurs d’événements. Je cherche à définir mon positionnement et la proposition de valeur la mieux adaptée à mon public cible.

P – PERSONA

Définition du persona : Décrivez ensuite le rôle professionnel que ChatGPT doit incarner pour vous répondre.

Vous définissez :

- Quelle expertise l’IA doit-elle avoir ?

- Quel profil professionnel précis ?

- Quelle expérience/légitimité ?

- Quelles références (entreprises, secteurs) ?

L’utilité des personas à un temps été discuté. Après plus de 200 tests, je confirme que la définition d’un persona ne change pas le type d’information qui est retourné.

Néanmoins, un persona détaillé change radicalement le ton, le vocabulaire et les recommandations proposés par chatGPT, Gemini ou Claude. C’est la raison pour laquelle, cette pratique est devenue un standard et continue d’être recommandée dans le guide Google prompting guide 101.

Exemple de persona : « Tu es un expert en stratégie marketing et business development. Tu maîtrise la méthode « Value proposition design » de Strategyzer pour créer une proposition de valeur qui répond fidèlement aux besoins du marché cible. »

T – TÂCHE

Définition de la tâche : Il s’agit d’indiquer à votre LLM les différentes tâches que vous attendez de lui. Considérez la tâche comme un ordre de mission. Utilisez des verbes d’actions.

Vous renseignez :

- L’objectif de la réponse.

- Les différentes tâches à accomplir.

- La manière de traiter les informations.

- L’approche méthodologique à employer.

Si le persona définit les compétences que l’on recrute, la tâche fixe le cahier des charges.

Exemple de tâche : « Ton rôle est d’aider l’utilisateur à définir sa proposition de valeur unique. Analyse les différents problèmes rencontrés. Analyse les différents besoins du public cible. Ensuite, formule quatre propositions de valeur unique selon la méthode Strategyzer. »

F – FORMAT

Définition du format : ChatGPT ne devinera pas la structure exacte du livrable que vous attendez, vous devez lui indiquer.

Spécifiez :

- Le type de document (email, article, liste…).

- La longueur précise (nombre de mots ou de caractères).

- La structure interne (tableau, sections, liste à puces…).

- Template de sortie (modèle à suivre, format JSON…).

- Style (ton, vocabulaire, niveau de langage…).

Spécifier le format souhaité élimine les allers-retours. ChatGPT sait exactement quoi livrer. Vous n’avez plus qu’à copier/coller.

Exemple de Format : « Tu fourniras un rapport complet sur la création de la proposition de valeur unique selon la structure suivante :

- Objectifs clients (customer jobs) : liste les 10 plus gros objectifs que ma cible cherche à atteindre selon les segments de marché identifiés.

- Douleurs (customer pains) : liste les 10 plus grosses douleurs ressenties par ma cible

- Gains recherchés (customer gains) : liste les 10 plus grosses transformations que ma cible espère obtenir grâce à ma solution.

- Proposition de valeur unique : Formule une proposition de valeur unique, la promesse que fait mon entreprise à ses clients ainsi qu’un descriptif de la manière dont elle répond à leurs besoins »

Créez gratuitement votre bibliothèque de contextes avec le Starter kit

- Définition du marché cible

- Positionnement

- Proposition de valeur

- Listing des besoins clients

Autant de données importantes pour enrichir les résultats fournis par vos LLMs et obtenir des réponses vraiment centrées sur vos besoins.

6 techniques de prompt engineering avancé à connaître

La structure CPTF, c’est la logique de base pour la création de vos prompts. Mais les 6 techniques qui viennent sont vos multiplicateurs de puissance. Chaque technique répond à un besoin spécifique. Vous pourrez les combinez selon votre objectif.

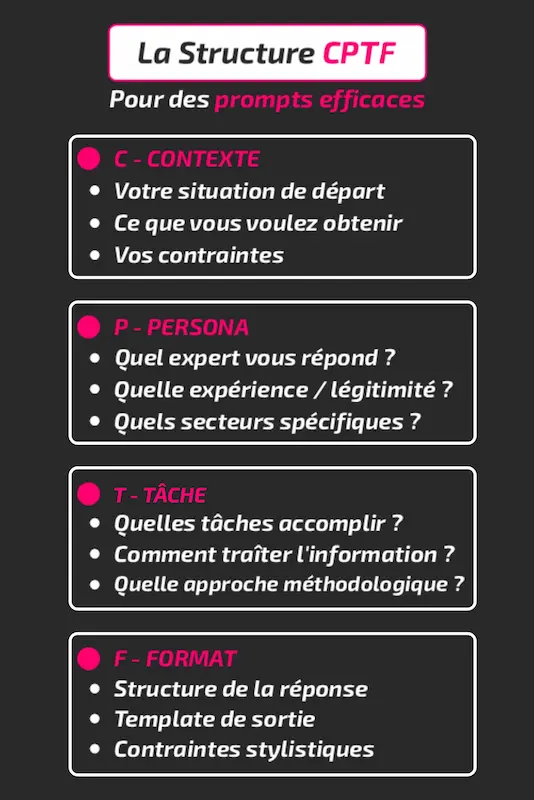

Zero shot | One shot | Few shots

Zero shot prompting

Lorsque vous vous limitez au framework CPTF, vous écrivez un prompt dit « zéro shot ». Mais il est possible d’améliorer la qualité des réponses en ajoutant des exemples du résultat souhaité.

One shot prompting

En ajoutant un exemple, votre modèle LLM comprendra mieux le format souhaité et suivra strictement la structure demandée. ChatGPT pourra également reproduire le style d’écriture ou le ton de votre exemple, mais sera beaucoup moins créatif que si l’on fournit un échantillon de plusieurs exemples.

Few shots prompting

Ici, on va compléter notre prompt CPTF avec plusieurs exemples du résultat que l’on souhaite obtenir. En multipliant les exemples, chatGPT prédiera plus précisément le résultat que vous souhaitez obtenir.

Si vous souhaitez reproduire une manière d’écrire ou un ton caractéristique, le few shots prompting capturera mieux l’essence du style d’écriture qu’avec un prompt zero shot ou one shot.

Exemple de prompt one shot

[contexte] : Je veux enregistrer une vidéo Tiktok sur les techniques de gestion du stress pour les femmes enceintes. J’ai besoin d’une accroche percutante pour attirer l’attention de mon public cible dès le début de ma vidéo.

[persona] : Tu es un Copywriter senior spécialisé TikTok, avec 500k followers cumulés, dans la thématique « maternité ».

[tâche] : Avec ta connaissance de mon sujet et de mon public cible, génère 3 accroches percutantes en faisant varier les angles.

[format] :

– Accroche 1 : [phrase d’accroche complète] + [pourquoi ça fonctionne]

– Accroche 2 : [phrase d’accroche complète] + [pourquoi ça fonctionne]

– Accroche 3 : [phrase d’accroche complète] + [pourquoi ça fonctionne]

[Exemple] :

Sujet : Alimentation équilibré pour les futures maman.

Accroche 1 : « Ces 3 aliments boostent le cerveau de votre futur bébé ».

– ça fonctionne car : promesse concrète + visuel appétissant.

Accroche 2 : « Arrête tout de suite de manger cet aliment si tu es enceinte ».

– ça fonctionne car : urgence + mise en garde + autorité.

Accroche 3 : « Fringales incontrôlables pendant la grossesse ? J’ai une solution pour toi ! »

– ça fonctionne car : identification au problème + solution immédiate.

Exemple de prompt few shot

[contexte] : J’ai collecté 250 avis clients sur la plateforme trustpilot. J’aimerais analyser la perception de mes services par mes clients pour améliorer ma réputation. J’ai joint le fichier pdf qui recense tous les avis collectés.

[persona] : Tu es un expert marketing spécialisé dans l’optimisation du service client et dans la gestion de la réputation en ligne.

[tâche] : Analyse mes avis clients. Extrait les insights et les retours important. Formule ensuite des recommandations sur les mesures à prendre.

[format] :

– Nombre d’avis positifs.

– Nombre d’avis neutres.

– Nombre d’avis négatifs.

– Pourcentage d’avis positifs | neutres | négatifs

– Liste des informations essentielles extraites des avis clients.

– Recommandations

[Exemple 1] : « Service ultra-rapide et conseils personnalisés top, je recommande à 100% ! » → Positif

[Exemple 2] : « Livraison standard, produit conforme à la description sans surprise. » → Neutre

[Exemple 3] : « Problème de remboursement non résolu après 2 semaines, déçu. » → Négatif

[Exemple 4] : « Excellente qualité et support réactif, parfait pour mon business ! » → Positif

[Exemple 5] : « Commande arrivée avec délai annoncé, rien à redire. » → Neutre

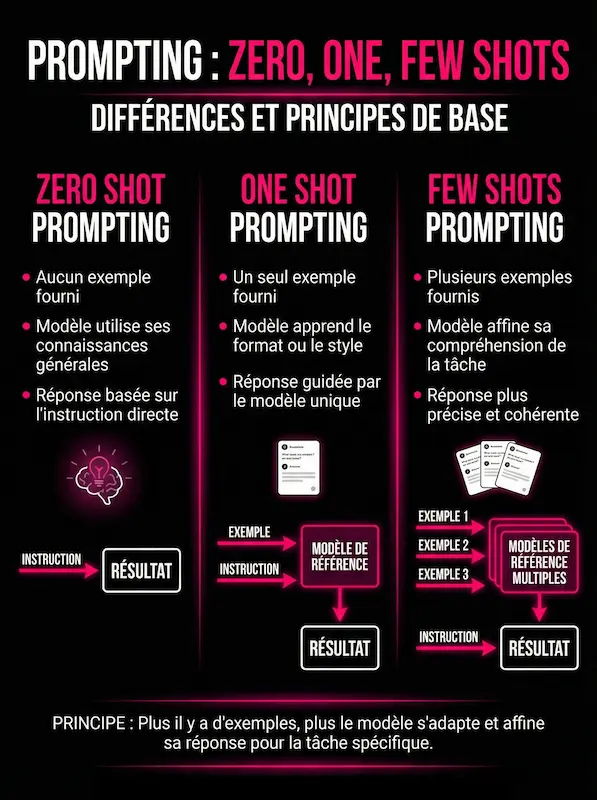

La pratique de l’ « in-context learning » qui consiste à intégrer des exemples directement dans le prompt pour guider le modèle, améliore la compréhension textuelle. Elle se distingue des pratique CAG (Cache/Context-augmented generation) et RAG (Retrieval-Augmented generation) où l’on fournit des documents supplémentaires sur lesquels le modèle basera son raisonnement.

CAG & RAG : Maîtrisez les connaissances de votre IA

Avec les méthodes CAG et RAG, l’utilisateur apporte des documents que le modèle utilisera ensuite comme base de connaissances supplémentaires.

CAG – Cache/Context Augmented Generation

Le CAG est une méthode où des documents de référence (PDF, images, CSV, pages, notes, etc.) sont directement importés dans le cache mémoire du chatbot afin d’être utilisés immédiatement par le modèle comme éléments de contexte.

Comme ces documents sont placés dans la “mémoire de travail » du modèle, le CAG est limité par la taille de la fenêtre contextuelle.

Au-delà d’un certain volume, tout ne peut pas être chargé ou conservé simultanément.

Si vous avez utilisé le Starter Kit de Startup-Now, c’est la méthode qui est utilisé quand vous chargez les pdf de votre marché cible et des besoins clients pour générer votre proposition de valeur.

Quand vous téléchargez un pdf sur chatGPT ou quand vous fournissez une image de référence à nanobanana, vous utilisez la méthode CAG.

Exemple de prompt avec un CAG :

Téléchargez dans chatGPT le document pdf de vos données de ciblage marché obtenus avec l’assistant niche detector de votre Starter kit Startup-Now.

Dans la fenêtre de chat, indiquez le prompt suivant :

[Contexte] : Je suis [un freelance/une entreprise/une marque] qui vend [vos produits/services]. J’ai joint un descriptif de mon marché cible.

[persona] : Tu es un business analyst spécialisé dans l’identification des données psychographiques de [votre secteur d’activité].

[Tâche] : ton rôle est d’identifier les 10 plus gros besoins, les 10 plus grosses frustrations et les objections majeures de mon marché cible vis-à-vis de ma solution.

[Format] :

*Besoins du marché :*

**besoin 1** [description du besoin 1]

**besoin 2** [description du besoin 2]

**besoin 3** [description du besoin 3]

…

*Frustrations du marché :*

**frustration 1** [description de la frustration 1]

**frustration 2** [description de la frustration 2]

**frustration 3** [description de la frustration 3]

…

*Objections du marché*

**Liste à puce des objections**

RAG – Retrieval Augmented Generation

Le RAG est une méthode où le modèle interroge une base de connaissances externe, généralement une base de données vectorielle. Conçu pour les gros volumes de documents, la requête de l’utilisateur est d’abord utilisée pour retrouver les passages pertinents dans le corpus de documents, puis les injecter dans le contexte avant de répondre.

L’avantage de cette méthode est que vous gardez le contrôle sur la manière dont les documents sont traités pour le stockage et la restitution des informations. Par contre, pour créer votre base de connaissances, vous devrez certainement utiliser des logiciels d’automatisation comme N8N, activepieces ou Flowise.

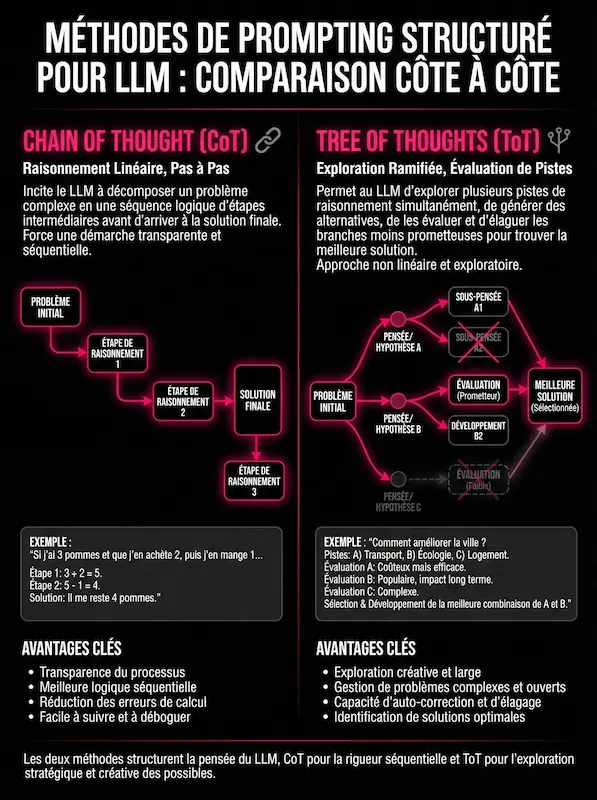

Chain-of-thought (CoT) : Le pouvoir de la démonstration

Peut-être vous souvenez-vous encore des exercices de mathématiques ou de physiques à l’école. On nous demandait de décomposer, étape par étape, tout notre raisonnement. En tant qu’élève, je trouvais ça stupide, car la plupart du temps, les calcules étaient simples et pouvaient être calculés de tête.

Et puis, en s’attaquant à des problèmes infiniment plus complexes, j’ai compris l’intérêt de pouvoir réviser les étapes précédentes pour détecter une erreur.

C’est le même principe pour la méthode Chain-of-thought, littéralement la pensée en chaîne. On va demander à notre modèle d’intelligence artificielle de progresser étape par étape et de décomposer son raisonnement jusqu’au résultat final. Cette pratique réduit drastiquement les hallucinations et vous permet de mieux contrôler la qualité du résultat généré.

Concrètement, lorsque l’on rédige la partie « tâche » de notre structure CPTF, on va détailler les étapes intermédiaires à respecter pour la réalisation de la tâche comme dans l’exemple suivant :

Exemple de prompt Chain-of-Thought :

Contexte : Je suis graphiste freelance et je souhaite attirer des clients PME sur LinkedIn, mais je ne sais pas quoi raconter qui ne soit pas trop technique.

Identification de la solution : Pour chaque problème, identifie comment mon expertise de graphiste apporte une solution concrète et rentable.Brainstorming des sujets : Croise les problèmes et les solutions pour générer 5 angles de sujets éducatifs (pas de vente directe).Sélection des formats : Pour chaque sujet, recommande le format le plus adapté (Carrousel, texte court, image avant/après, etc.).Analyse de la cible : Liste d’abord 3 problèmes urgents ou « points de douleur » que rencontrent les patrons de PME avec leur image de marque actuelle.

Tree of Thoughts (ToT): La réunion d’équipe… tout seul

Si le

Générer plusieurs pistes de réflexion.Évaluer chaque piste (les « challenger »).Éliminer les mauvaises idées.Conserver et développer uniquement la gagnante.

C’est une technique redoutable pour la stratégie ou la création de contenu complexe. C’est comme avoir trois consultants dans une pièce qui débattent pour vous trouver la pépite, sauf que c’est gratuit et immédiat.

Exemple de prompt Tree-of-thoughts :

Pour cet exemple, on s’attaque à un problème classique du solopreneur :

Branche 1 (Brainstorming) : Propose 3 concepts radicalement différents (ex: un outil pratique, un mini-cours audio, un diagnostic).Branche 2 (Critique – L’avocat du diable) : Pour chaque concept, liste impitoyablement les défauts potentiels (trop long à consommer ? valeur perçue trop faible ? déjà vu ?).Branche 3 (Sélection) : Choisis le concept gagnant qui offre le meilleur équilibre entre « facilité de consommation » pour le prospect et « autorité » pour moi.Résultat final : Développe le titre accrocheur et le plan détaillé du concept gagnant.

La méthode du Prompt Chaining ou Iterative Prompting

Ceux qui me connaissent savent que j’évite soigneusement les protocoles magiques ou l’on obtiendrait un résultat final dès le premier prompt.

Les LLMs sont des modèles qui reposent sur des statistiques successives qui se basent sur le résultat précédent. Un peu comme le jeu du téléphone arabe. Si la première information est légèrement déformée, la suivante le sera encore plus, et à la fin, le message n’a plus rien à voir. Chaque déviation en début de processus est amplifiée par l’étape suivante. Ce n’est pas sérieux si on veut utiliser le potentiel de ces intelligences artificielles pour des besoins professionnels.

Pour garder le contrôle, j’ai recours à la méthode du « prompt chaining », appelée aussi « iterative prompting » selon les études.

Le principe est simple : Une tâche = un prompt.

Vous co-construisez avec votre IA, étape par étape, en gardant un total contrôle sur vos production et en corrigeant au plus tôt les erreurs de prédiction.

Par exemple, lorsque j’écris un article, voilà le processus que je suis :

- Idéation : Je sélectionne une idée de contenu dans mon stock ou je demande à perplexity de me fournir des idées de contenus qui intéressent mon audience cible (avec CAG).

- Recherche documentaire : je demande à une IA d’explorer le sujet avec une méthode Tree-of-thoughts pour obtenir un rapport complet.

- Angle et Accroche : Je demande de commencer par suggérer 3 angles possibles pour aborder mon sujet.

- Brief SEO : Ensuite, je demande un brief SEO avec le plan d’article, les mots clés importants et les questions les plus fréquemment posées sur internet.

- Rédaction : Si je veux rédiger avec l’IA, je demande d’abord de générer la section 1, puis la 2… Pour pouvoir éditer au fil de l’eau et garder de la cohérence entre les sections. Et je finis par générer l’introduction et la conclusion.

Avec ce processus, c’est vous qui décidez de votre niveau d’implication. Vous pouvez partir du brief SEO et tout rédiger vous-même pour ne pas trahir votre ton et garder votre authenticité. Ou vous optez pour une génération complète par IA pour des textes techniques où votre voix n’a pas de valeur ajoutée.

Bonus : 21 modèles prêts à l’emploi

Chaque template suit le framework CPRF et intègre 1 ou plusieurs des 6 techniques.

Comment les utiliser :

- Copiez le template

- Remplacez les [crochets] par vos informations

- Soumettez à ChatGPT

- Obtenez un résultat exploitable à 80%+

Organisation :

- Templates 1-6 : Techniques avancées pures

- Templates 7-10 : Création de contenu

- Templates 11-13 : Communication commerciale

- Templates 14-15 : Productivité/Organisation

- Templates 16-18 : Analyse/Stratégie

- Templates 19-21 : Formation/Pédagogie

F.A.Q

Q1 : Qu’est-ce que le prompt engineering exactement ?

Le prompt engineering est l’art de rédiger des instructions précises pour guider les IA génératives (ChatGPT, Claude, Gemini) vers les résultats souhaités. C’est la différence entre obtenir du contenu générique inutilisable et du contenu sur-mesure parfaitement adapté à vos besoins. Concrètement, il s’agit de structurer vos demandes avec contexte, persona, résultat attendu et format de sortie pour maximiser la qualité des réponses de l’IA.

Q2 : Combien de temps faut-il pour maîtriser le prompt engineering ?

Avec les bonnes techniques, vous pouvez améliorer significativement vos résultats dès les premiers prompts. Maîtriser les bases (méthode CPTF et techniques essentielles) prend 2-3 heures de lecture et pratique. Devenir vraiment expert demande quelques semaines de pratique régulière et d’itération. L’essentiel : commencez immédiatement avec des templates éprouvés, testez, mesurez, ajustez.

Q3 : Faut-il des compétences techniques pour faire du prompt engineering ?

Non, le prompt engineering repose sur la logique et la communication claire, pas sur des compétences de programmation. Comme le dit Andrej Karpathy, ancien directeur IA chez OpenAI : « l’anglais est en train de devenir le langage de programmation le plus tendance ». Cela vaut aussi pour le français. Si vous savez expliquer clairement ce que vous voulez à un humain, vous pouvez le faire avec une IA. Les frameworks comme CPTF structurent simplement cette communication.

Q4 : Quels sont les outils indispensables pour débuter en prompt engineering ?

Pour débuter, ChatGPT (gratuit ou Plus à 20$/mois), Claude (gratuit ou Pro) ou Gemini suffisent amplement. Choisissez selon votre besoin : ChatGPT pour la créativité, Claude pour l’analyse précise, Gemini pour la recherche d’infos récentes. Complétez ensuite avec des ressources gratuites comme PromptBase pour des templates, OpenAI Playground pour tester avec contrôle fin des paramètres, et Learn Prompting pour la formation continue.

Q5 : Comment éviter que l’IA invente des informations (hallucinations) ?

Soyez ultra-spécifique dans vos demandes, ajoutez des contraintes claires (« fournis les sources vérifiables »), demandez explicitement des références quand nécessaire, et vérifiez TOUJOURS manuellement les informations factuelles critiques (statistiques, citations, dates, noms). Technique efficace : demandez à l’IA d’indiquer explicitement « Information non vérifiée » plutôt que d’inventer. Croisez aussi les réponses entre plusieurs IA. L’IA reste un assistant, pas une source de vérité absolue.

Q6 : Le prompt engineering va-t-il disparaître avec l’amélioration des IA ?

Au contraire, le prompt engineering devient THE compétence IA la plus demandée en 2024 selon LinkedIn. Plus les IA évoluent et se spécialisent, plus savoir les diriger précisément devient un avantage concurrentiel stratégique. Les modèles deviennent plus puissants, mais aussi plus complexes à optimiser. Maîtriser le prompt engineering, c’est comme maîtriser Excel ou Google Ads : une compétence pérenne qui évolue mais reste fondamentale pour exploiter pleinement la technologie.

Q7 : Peut-on mesurer l’efficacité d’un prompt ?

Oui, absolument. Par des métriques qualitatives (pertinence du contenu, originalité, cohérence avec la brand voice) et quantitatives (taux de conversion, temps gagné vs création manuelle, taux d’engagement, nombre d’itérations nécessaires). L’approche scientifique : testez toujours 2-3 variantes de prompts (A/B test), mesurez les résultats sur des critères définis à l’avance, documentez ce qui fonctionne. Les meilleurs prompt engineers maintiennent une bibliothèque de prompts gagnants avec métriques associées.